- Что такое CPU

- Что такое GPU

- Отличие CPU от GPU

- Что такое графический процессор

- Технические особенности GPU

- Зачем и где используется GPU

- История появления графических процессоров

- Интегрированная или внешняя (дискретная) видеокарта

- Интегрированная (встроенная) видеокарта

- Внешняя (дискретная) видеокарта

- Характеристики видеокарт

- Производитель

- Тактовая частота ядра и памяти

- Тип и объем видеопамяти

- Разрядность шины памяти

- Система охлаждения

- Интерфейсы или разъемы подключения

Графический адаптер также используется для редактирования любого изображения, будь то отслеживание видео на YouTube или редактирование фотографий в Photoshop. В результате выполнение вычислений может быть проблематичным, если GPU недостаточно.

Что такое CPU

Центральный процессор — это центральный процессор.

Его основная функция — выполнение цепочки команд за минимально возможное время.

Центральный процессор предназначен либо для одновременного выполнения нескольких цепочек, либо для разделения команд одной цепочки, выполнения их по отдельности и объединения в одну в правильном порядке. Каждая команда в потоке зависит от команд, которые следуют за ней. Именно поэтому в CPR очень мало блоков исполнения, и весь упор делается на скорость исполнения и сокращение времени прерывания, что достигается с помощью кэша и конвейера.

Если вы хотите узнать, как работают процессоры, а также что они собой представляют, прочитайте эту статью.

Что такое GPU

GPU — это графический процессор.

Его основная функция — рендеринг 3D-графики и визуальных эффектов.

Графические процессоры принимают полигоны в качестве точки входа и после выполнения необходимых математических и рациональных действий извлекают пиксели. По сути, работа графического процессора заключается в выполнении огромного количества задач, которые не зависят друг от друга. В результате он содержит огромное количество блоков исполнения — в современных GPU их более 2048.

Отличие CPU от GPU

Теперь, когда мы прояснили понятие, давайте рассмотрим различия между CPU и GPU.

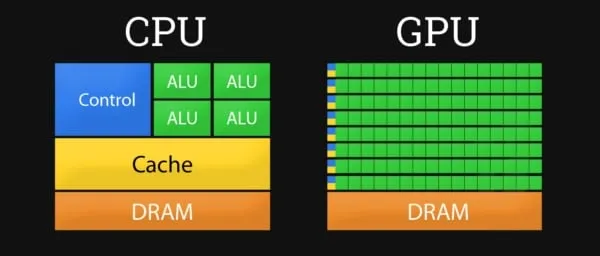

- Доступ к памяти. В GPU он связанный и легко предсказуемый — если из памяти читается элемент текстуры, то через некоторое время настанет очередь и соседних текселов. С записью ситуация аналогичная.

- Размер кэш-памяти. Графическому процессору, в отличие от универсальных процессоров, не нужна кэш-память большого размера. Для текстур требуются лишь 128–256 килобайт.

- Поддержка многопоточности. Центральный процессор исполняет 1 – 2 потока вычислений на одно ядро, а графический процессор может поддерживать несколько тысяч потоков на каждый мультипроцессор, которых в чипе несколько штук. И если переключение с одного потока на другой для CPU стоит сотни тактов, то GPU переключает несколько потоков за один такт.

- Архитектура. В CPU большая часть площади чипа занята под буферы команд, аппаратное предсказание ветвления и огромные объемы кэш-памяти, а в GPU большая часть площади занята исполнительными блоками.

Схематическая диаграмма центральных и графических процессоров

CPU и GPU — это процессоры. Хотя они имеют много общего друг с другом, они были созданы для выполнения разных обязанностей. Прочитайте эту статью, чтобы узнать, чем именно отличаются CPU и GPU.

Что такое графический процессор

GPU (графический процессор) — элемент компьютера, игровой консоли, планшета или смартфона, предназначенный для работы с графикой, то есть преобразования кода в изображения, в основном трехмерные. Массовое использование таких устройств началось в 2000 году.

До этого функциональность процессора была достаточной как для разработчиков, так и для пользователей. Игры и программы были настолько примитивными, что дополнительные элементы были недоступны. Некоторые пиксельные конструкции, такие как первые игры и графические процессоры, не требовали большой вычислительной мощности.

С появлением 3D-графики и первых игр в этом формате все изменилось. Было показано, что процессоры, способные полностью обрабатывать арифметические операции, даже не примитивную низкополигональную графику, начинают «дристать».

Дальнейший рост в этом направлении привел к появлению современных видеокарт, в которых используются графические процессоры. Это очень мощное устройство, которое полностью справляется с каждой операцией. И в этом нет ничего странного. Катсцены в современных ААА-играх уже практически неотличимы от 3D-анимации.

Технические особенности GPU

По сравнению с CPU, GPU имеет меньший набор команд (намеренно ограниченный) и немного другую архитектуру для обработки текстур и 3D-объектов.

GPU изначально разрабатывались как полиномиальные элементы с несколькими ядрами, поэтому они очень мощные. CPU выполняют непрерывные численные вычисления, тогда как GPU предназначены для одновременной обработки нескольких объектов, то есть для массивно-параллельных вычислений. Что касается технической реализации, то интегрирован GPU, который производится на том же чипе, что и CPU. И он является частью видеокарты, вместе с видеопамятью и некоторыми другими аксессуарами.

Если сравнивать вычислительную мощность, то последний является более мощным. Встроенный обычно является графическим ускорителем, который можно использовать для простых вычислений.

Конкуренция между различными брендами привела к тому, что сегодня только две компании производят графические чипы для видеокарт — Nvidia и AMD. Последняя поглотила ATI, бывшую независимую компанию по производству видеочипов Radeon.

Что касается того, какая марка лучше, то, на мой взгляд, вопрос некорректен. Такие сравнения были одним из вопросов в «священной войне» Интернета за «материалы» на протяжении десятилетий. Не у всех есть удачные модели, но есть удачные модели, и при покупке графического адаптера следует обратить внимание на определенные модели.

Конкуренция между этими двумя «китами» для рядового пользователя означает лишь несовместимую борьбу. В поисках денег потенциальных покупателей каждый пытается создать графический процессор с лучшими характеристиками.

Ну, внешний вид новой модели автоматически включает в себя сцены из старой модели.

Зачем и где используется GPU

Первое, что приходит в голову по крайней мере нескольким пользователям, разбирающимся в компьютерах, — это видеоигры. Правильно: киберспорт — это та отрасль, где видеокарты используются по максимуму. Сегодня трудно представить себе «серьезную» игру, которая не была бы реализована в 3D. Большинство игр несколько похожи друг на друга. Действие происходит в трехмерном мире от первого или третьего лица, и все они должны быть отнесены видеокартой.. Другие типы игр, использующие изометрические изображения, такие как стратегии и MOBA, уже давно используют те же трехмерные модели.

Однако видеоигры — не единственная отрасль, где требуются графические процессоры. Рассмотрим недавние рекламные кампании о майнинге криптовалют, особенно биткоина, и последующее массовое распространение на рынке видеокарт, которые ранее использовались для майнинга.

Сегодня этот вопрос теряет актуальность. Трудолюбивые китайцы изобрели майнер — устройство, в котором нет графического чипа, но видеокарта даже лучше.

Графический адаптер также используется для редактирования любого изображения, будь то отслеживание видео на YouTube или редактирование фотографий в Photoshop. В результате выполнение вычислений может быть проблематичным, если GPU недостаточно.

Следите за мной в социальных сетях, чтобы получать обновления. До скорой встречи!

Сегодня мы рассмотрим очень важный внутренний аксессуар, GPU или графический процессор в каждом компьютере. Мы расскажем, что это такое, чем он отличается от видеокарты и другие важные детали, которые вам необходимо знать. Поехали!

История появления графических процессоров

Это, пожалуй, один из самых сложных и запутанных путей развития компьютеров, и начинается он, как многие могут подумать, не с создания примитивной 2D или 3D графики, а с создания простейшего текста на монохромном экране.

Стоит отметить, что вместо того, чтобы рассматривать всю дату графического адаптера, можно рассмотреть только самые важные и значимые моменты истории.

Давайте начнем с их серии.

Первым графическим адаптером был MDA (Monochrome Display Adapter), разработанный в 1981 году; MDA был основан на чипе Motorola 6845 и имел 4 Кб видеопамяти. Он работал только в текстовом режиме с разрешением 80 x 25 символов и поддерживал пять свойств текста: простой, яркий, обратный, подчеркивание и мигание. Передача цветной или графической информации была невозможна; цвет текста определялся используемой моделью экрана.

Однако прародителем современных видеокарт является CGA (Colour Graphics Adapter), выпущенный компанией IBM в 1981 году. CGA может работать в текстовом режиме с разрешением 80 x 25 и графикой до 640 x 200 пикселей. 16 цветов.

С момента появления первых графических адаптеров CGA в 1981 году и вплоть до 1991 года инноваций не было от слова «совсем». В основном разработчики и дизайнеры посадочных материалов представляли себе небольшое увеличение анализа, цветов и т.д.

И только в 1991 году появилось понятие SVGA (Super VGA). Это расширение VGA с новыми функциями и дополнительными сервисами, например, возможностью регулировки произвольной частоты кадров. Количество одновременно отображаемых цветов увеличилось до 65 536 (высокий цвет, 16 бит) и 16 777 216 (истинный цвет, 24 бита), с дополнительными функциями для отображения как текста, так и визуальных данных. SVGA стал стандартом де-факто для видеоадаптеров примерно в 1992 году, после того как VESA приняла VBE (VESA BIOS Extens) версии 1.0. До этого момента почти все SVGA-видеоадаптеры были несовместимы друг с другом.

Вам это еще не надоело? Если нет, рекомендуем продолжить и перейти к анализу интегрированных видеокарт.

Интегрированная или внешняя (дискретная) видеокарта

Интегрированная (встроенная) видеокарта

Встроенная видеокарта — это видеокарта, которая уже встроена в процессор или материнскую плату. Большинство современных процессоров AMD и Intel имеют графическое ядро, интегрированное в процессорный чип, используемый для вывода графики, а также в процессорный чип.

Решения со встроенным графическим процессором (видеокартой) очень популярны в ноутбуках и другой портативной электронике, где небольшие размеры устройства позволяют использовать отдельное решение для внешнего вывода.

Комплексные графические решения часто ниже по общей производительности и производительности отдельных внешних видеокарт и являются временным решением, пока не будет приобретена другая внешняя видеокарта (портативные и другие переносные электронные системы часто не имеют возможности замены видеокарты). Однако производительности видеочипа, встроенного в материнскую плату или процессор, вполне достаточно для повседневных задач, таких как навигация в Интернете, отслеживание видео с низким разрешением и офисные пакеты. Видеокарты, созданные на базе новейших процессоров Intel (начиная со встроенного графического ядра Intel HD Graphics 630) и AMD (начиная со встроенного графического ядра Radeon Vega 10), могут справиться с простыми, нетребовательными играми в формате Full HD Они способны справиться с простыми, нетребовательными играми в формате Full HD.

Кроме того, мы хотели бы отметить, что не все встроенные видеокарты имеют собственную видеопамять. В качестве видеопамяти интегрированные решения хранят конфигурируемый фрагмент оперативной памяти для собственного использования и будущей работы.

Стоит отметить, что не все процессоры и материнские платы имеют интегрированные графические процессоры. Если вы рассматриваете возможность использования встроенной видеокарты в качестве временного решения, проверьте ее перед покупкой.

Внешняя (дискретная) видеокарта

Внешние или разные видеокарты — это устройства на отдельных платах (независимые видеоядра), установленные на отдельных панелях AGP (Accelerated Graphics Port (ACP) или PCI (Peripheral Component Interconnect).

Дискретные видеокарты являются наилучшим графическим решением, поскольку отдельные карты содержат отдельный графический процессор и отдельный набор видеопамяти. Процессор.

Из-за эффективной разницы в производительности по сравнению с интегрированными графическими решениями рабочая температура видеокарты прямо пропорционально увеличивается. Поэтому в массовых холодильниках для тепловой индукции устанавливаются всевозможные высокопроизводительные решения, а количество холодильников, используемых для охлаждения, может достигать трех или четырех.

Дискретные видеокарты могут быть заменены в будущем, если производительность текущих видеокарт окажется недостаточной для запуска новых требовательных игр и графических приложений.

Характеристики видеокарт

А теперь, хватит «лирики», давайте рассмотрим основные функции видеокарты. Ниже приведены только основные характеристики видеокарты. При выборе видеокарты стоит обратить внимание на ее основные технические характеристики. И это без учета таких деталей, как процессор, количество блоков CUDA, количество растянутых блоков и т.д.

Производитель

Как водится, рынок видеокарт делится на двух игроков — «красных» и «зеленых». Термин «Красный» должен означать графические решения от AMD -Radeon, а термин «Зеленый».

Другую статью о выборе видеокарты можно найти здесь. ‘Как выбрать видеокарту для компьютера?’ Какая видеокарта лучше: AMD или NVIDIA?».

Тактовая частота ядра и памяти

Здесь частота видеокарты может быть прямо пропорциональна тактовой частоте процессора, с единственным отличием — частотой видеопамяти и самого графического процессора.

Поэтому чем выше тактовая частота GPU и памяти, тем выше производительность видеокарты.

Стоит добавить, что большинство видеокарт можно разгрузить или перегрузить с помощью специального программного обеспечения для перегрузки. В некоторых случаях повышение эффективности может достигать от 5% до 20%. Однако не стоит забывать и о другой стороне медали — возможности появления артефактов и графических ошибок в различных приложениях, возможной деградации видеокарты и ускоренного перегрева.

О разгоне видеокарт вы можете прочитать в другой статье «Разгон видеокарт».

Тип и объем видеопамяти

Видеопамять — это отдельная, независимая память, приваренная к плате видеокарты и необходимая для работы с графикой, выполняемой видеокартой.

Существующие сегодня на рынке видеокарты предлагают следующие типы видеопамяти: GDDR3, GDDR4, GDDR5, GDDR6 и GDDR6X. Основным параметром, определяющим объем видеопамяти и ее тип, является пропускная способность памяти. Однако объем видеопамяти не всегда отражается на производительности видеокарты, необходимо учитывать и другие важные характеристики, такие как тип используемой памяти и ширина канала.

В результате, чем меньше тип используемой памяти и чем выше ее объем, тем лучше видеокарта может запускать/загружать новые текстуры в игру или использовать высококачественные текстуры и анализ.

Разрядность шины памяти

Ширина канала памяти определяет, насколько быстро процессор видеокарты взаимодействует с памятью карты памяти. Чем выше битовая глубина, тем быстрее происходит обмен этой информацией. Это важно для игр и требований к обработке графики.

Система охлаждения

Все очень просто — чем мощнее видеокарта, тем больше выделяется тепла. Поэтому все современные графические решения используют два или более охладителей (вентиляторов) для охлаждения видеопроцессора и памяти карты памяти.

Некоторые видеокарты могут работать тише, чем другие, поэтому, если показатели шума вас занимают, рекомендуется ознакомиться с оценками пользователей перед покупкой конкретной видеокарты.

Интерфейсы или разъемы подключения

Интерфейс подключения определяет, как экран или телевизор подключается к видеокарте и выводит изображение. В настоящее время экраны и телевизоры используют четыре разъема: DVI-I, DVI-D, VGA, HDMI и DisplayPort.